@zhangyy

2017-06-06T05:38:10.000000Z

字数 2472

阅读 423

电商离线数据分析

大数据项目

- 一: 项目介绍:

- 二: 运用相关的技术:

- 三: 应用环境搭建:

- 四: 案例测试出来:

一: 项目介绍

- 1.1 整体概述:

利用hadoop 的生态环境搭建出一套 电商离线分析平台满足以下需求1. 数据分析平台2. 推荐系统3. 业务系统的底层存储系统4. 业务监控系统 等。。。。。。。。

- 1.2 电商企业项目分析:

商品订单:商品的购买率---> 订单数量----> 网站的注册会员数量----> 网站的访客量x----> 网站的内容-----> 推广链接(百度访客)电商企业所关心的这些内容,就需要通过数据分析平台来提供

- 1.3 数据来源:

数据的来源:日志两种 日志数据系统运行日志:运行异常,服务器的配置 提供运维使用业务日志数据:1. 业务日志:用户行为数据用户行为日志从用户打开网站开始,在各个网页的一系列操作 用户行为用户行为数据的搜集:以监听事件的方式电商数据分析:离线和实时离线数据分析结果,提供个营销部分使用做为营销的参考

- 1.4 数据维度分析:

平台 : 用户的入口 pc 端(前端页面/后端业务系统) 移动端(android,ios,pad)时间 : 小 时,天,月 , 季度,年浏览器: 浏览器的类型(js 与浏览器的兼容问题) 浏览的版本地域: 仓库管理 京东快递 : 物流管理化 通过分析不同地域的用户量,用户行为 合理调配仓库管理本地化计算管理指标: 分析的访客量,用户量,会话量

二: 运用相关的技术:

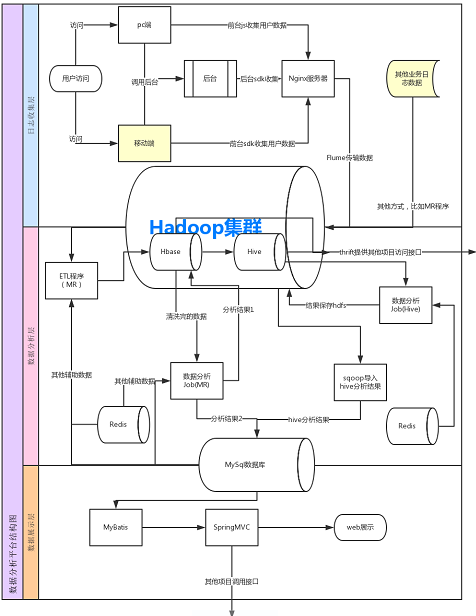

- 2.1 技术架构层

1. 日志提取层2. 数据分析层3. 数据展示层

相关技术交互图:

- 2.2 运用相关技术

linux + windows 下的eclipse 开发hadoop 生态环境

2.1.1 系统环境配置

centos6.4 x64 namenode01.hadoop.com整个环境搭建(伪分布环境) 可以参考 以前的配置

2.1.2 日志分析层构建

flume-ng+hadoop+nginx 平台构建hadoop + hadoop 平台构建参考 以前文档配置

1. nginx 环境配置

安装nginxrpm -ivh nginx-1.8.0-1.el6.ngx.x86_64.rpmrpm -ivh nginx-debug-1.8.0-1.el6.ngx.x86_64.rpm启动nginxservice nginx start

更改nginx 的主配置文件

cd /etc/nginx/mkdir -p www/sourcevim nginx.conf在最后增加:添加 主机server {listen 80;server_name namenode01.hadoop.com 0.0.0.0;location ~ .*(BfImg)\.(gif)$ {default_type image/gif;access_log /home/hadoop/access.log log_format;root /etc/nginx/www/source;}上传BFImg.gif 到 /etc/nginx/www/source;作为测试页面从新启动 nignxservice nginx restart

测试页面访问

http://192.168.3.1/BFImg.gif

2. flume 配置文件

su - hadoopcd yangyang/flume/conf

vim test2.conf

agent.sources = r1agent.sinks = k1agent.channels = c1## commonagent.sources.r1.channels = c1agent.sinks.k1.channel = c1## sources configagent.sources.r1.type = execagent.sources.r1.command = tail -F /home/hadoop/access.log## channels configagent.channels.c1.type = memoryagent.channels.c1.capacity = 1000agent.channels.c1.transactionCapacity = 1000agent.channels.c1.byteCapacityBufferPercentage = 20agent.channels.c1.byteCapacity = 1000000agent.channels.c1.keep-alive = 60#sinks configagent.sinks.k1.type = hdfsagent.sinks.k1.channel = c1agent.sinks.k1.hdfs.path = hdfs://namenode01.hadoop.com:8020/logs/%m/%dagent.sinks.k1.hdfs.fileType = DataStreamagent.sinks.k1.hdfs.filePrefix = BF-%Hagent.sinks.k1.hdfs.fileSuffix=.logagent.sinks.k1.hdfs.minBlockReplicas=1agent.sinks.k1.hdfs.rollInterval=3600agent.sinks.k1.hdfs.rollSize=132692539agent.sinks.k1.hdfs.idleTimeout=10agent.sinks.k1.hdfs.batchSize = 1agent.sinks.k1.hdfs.rollCount=0agent.sinks.k1.hdfs.round = trueagent.sinks.k1.hdfs.roundValue = 2agent.sinks.k1.hdfs.roundUnit = minuteagent.sinks.k1.hdfs.useLocalTimeStamp = true

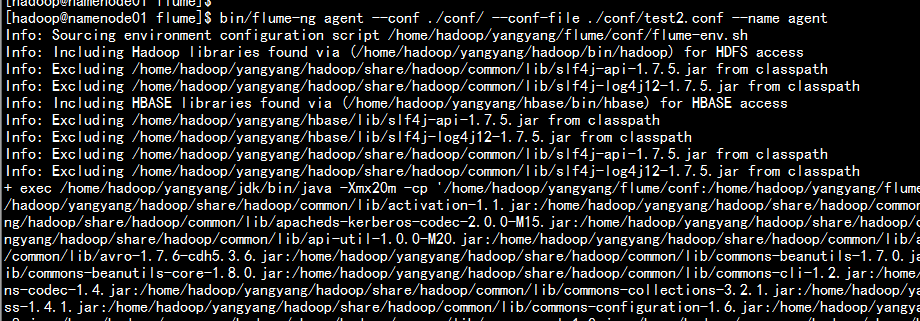

3. 启动flume 服务进行 日志收集

cd /home/hadoop/yangyang/flume/bin/flume-ng agent --conf ./conf/ --conf-file ./conf/test2.conf --name agent

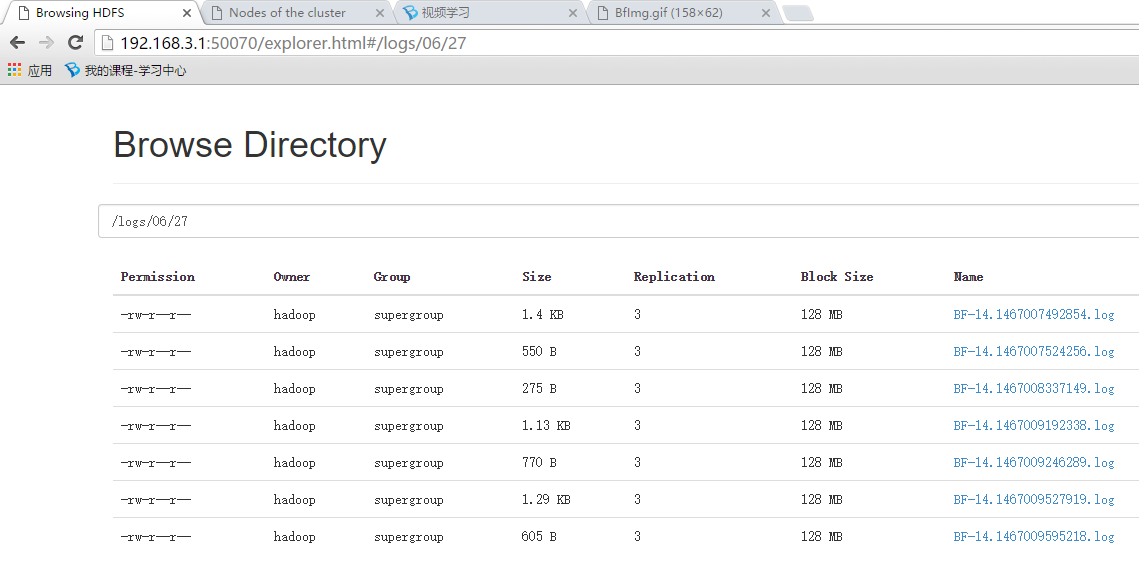

去hadoop 的hdfs 上面查看是否有数据生成。