@zhangyy

2020-07-20T06:03:00.000000Z

字数 2010

阅读 365

Hadoop HDFS Federation 配置

hadoop的部分

- 一:系统环境配置

- 二:编辑改变hadoop 的配置文件

- 三: 启动服务节点:

- 四:HDFS Federation环境测试

一:系统环境配置:

承接 在上文档hadoop 分布式的文档进行部署

二: 编辑改变hadoop 的配置文件

编辑core-site.xml 文件:master.hadop.com 的core-site 文件配置vim core-site.xml

<property><name>fs.defaultFS</name><value>hdfs://master.hadoop.com:8020</value></property><property><name>hadoop.tmp.dir</name><value>/home/hadoop/yangyang/hadoop/data</value></property></configuration>slave1.hadoop.com 的core-site.xml 文件配置<configuration><property><name>fs.defaultFS</name><value>hdfs://slave1.hadoop.com:8020</value></property><property><name>hadoop.tmp.dir</name><value>/home/hadoop/yangyang/hadoop/data</value></property></configuration>slave2.hadoop.com 的core-site.xml 文件配置:<configuration><property><name>hadoop.tmp.dir</name><value>/home/hadoop/yangyang/hadoop/data</value></property></configuration>

编辑hdfs-site.xml 文件:

<configuration><property><name>dfs.replication</name><value>3</value></property><property><name>dfs.nameservices</name><value>ns1,ns2</value></property><property><name>dfs.namenode.rpc-address.ns1</name><value>master.hadoop.com:8020</value></property><property><name>dfs.namenode.http-address.ns1</name><value>master.hadoop.com:50070</value></property><property><name>dfs.namenode.rpc-address.ns2</name><value>slave1.hadoop.com:8020</value></property><property><name>dfs.namenode.http-address.ns2</name><value>slave1.hadoop.com:50070</value></property></configuration>

三:启动服务节点:

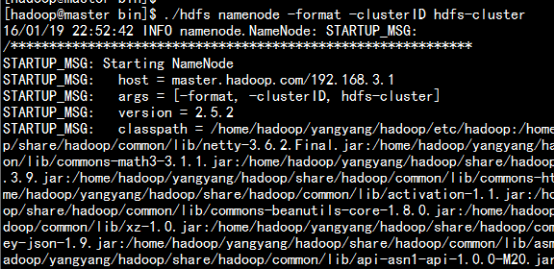

格式化HDFS 节点处理master.hadoop.comcd /home/hadoop/yangyang/hadoop/bin/hdfs namenode –format –clusterID hdfs-cluster

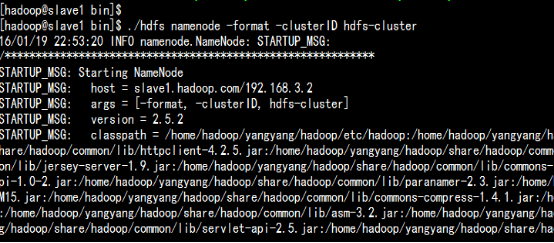

slave1.hadoop.comcd /home/hadoop/yangyang/hadoop/bin/hdfs namenode –format –clusterID hdfs-cluster

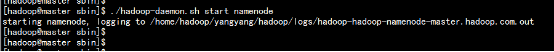

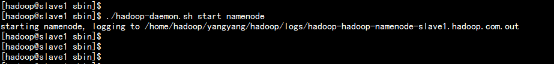

启动namenode.hadoop.com与slave1.hadoop.com节点上的namenodemaster.hadoop.com./hadoop-daemon.sh start namenode

slave1.hadoop.com./hadoop-daemon.sh start namenode

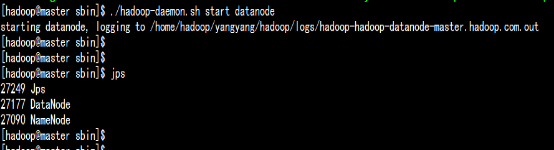

启动所有节点的datanonde./hadoop-daemon.sh start datanodemaster.hadoop.com

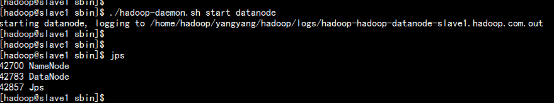

slave1.hadoop.com

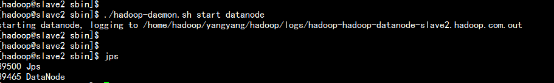

slave2.hadoop.com

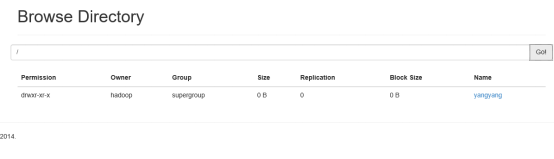

打开浏览器:

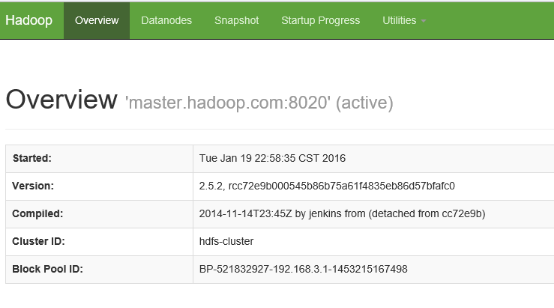

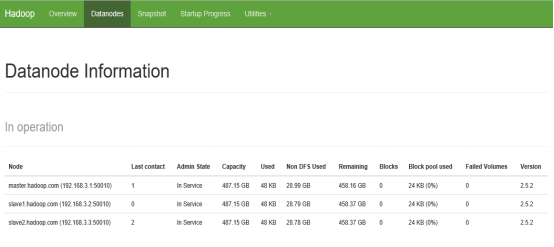

master.hadoop.com

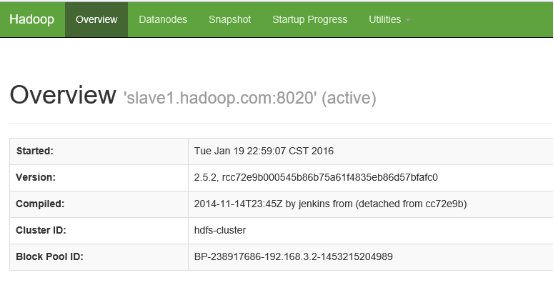

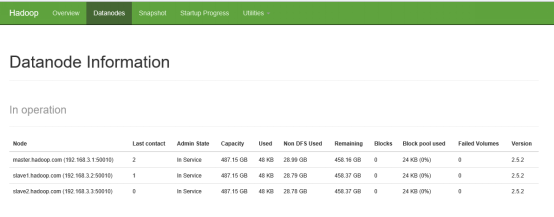

slave1.hadoop.com

四: HDFS Fedeation 的测试

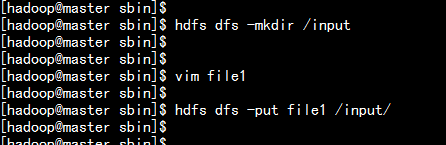

在maser.hadoop.com 节点上去HDFS创建一个文件

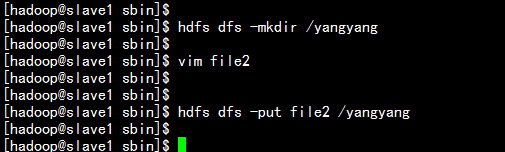

在slave1.hadoop.com 去hdfs 上创建文件

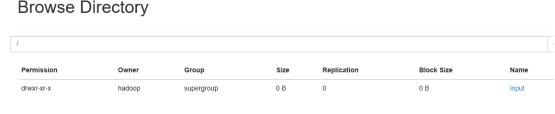

打开浏览器查看:

master.hadoop.com

slave1.hadoop.com