@iStarLee

2019-09-01T08:03:19.000000Z

字数 1204

阅读 947

NNDL —— 1 绪论

Deep-Learning

1 DL本质

DL本质上是解决贡献度分配问题(Credit Assignment Problem, CAP)

指样本的原始输入到输出目标之间的数据流经过多个线性或非线性的组件( components)。因为每个组件都会对信息进行加工,并进而影响后续的组件。当我们最后得到输出结果时,我们并不清楚其中每个组件的贡献是多少。

2 AI的主要流派

符号主义 符号主义 ( Symbolism):人类的认知过程可以看作是符号操作过程

连接主义 连接主义 ( Connectionism):在认知科学领域,人类的认知过程可以看做是一种信息处理过程。连接主义认为人类的认知过程是由大量简单神经元构成的神经网络中的信息处理过程,而不是符号运算。

3 神将网络简史

- 感知器是最早的具有机器学习思想的神经网络

- 1980, 反向传播算法解决了多层神经网络的学习问题,并成为最为流行的神经网络学习算法。

- 1983, 物理学家 John Hopfield 提出了一种用于联想记忆( Associative Memory)的神经网络,称为Hopfield网络

- 1984年, Geoffrey Hinton提出一种随机化版本的Hopfield网络,即玻尔兹曼机 ( Boltzmann Machine)

- 2006年,Hinton and Salakhutdinov [2006]发现多层前馈神经网络可以先通过逐层预训练,再用反向传播算法进行精调的方式进行有效学习。深度学习的崛起...

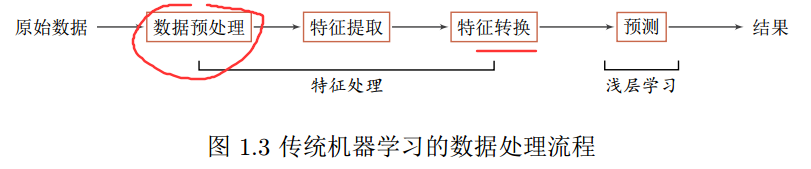

4 机器学习数据处理流程

- 数据预处理:经过数据的预处理,如去除噪声等。比如在文本分类中,去除

停用词等。

- 特征提取:从原始数据中提取一些有效的特征。比如在图像分类中,提取边

缘、尺度不变特征变换( Scale Invariant Feature Transform,SIFT)特征等。

- 特征转换:对特征进行一定的加工,比如降维和升维。降维包括特征抽取( Feature Extraction)和特征选择 ( Feature Selection)两种途径。常用的特征转换方法有主成分分析( Principal components analysis, PCA)、线性判别分析( Linear Discriminant Analysis)等

- 预测:机器学习的核心部分,学习一个函数进行预测

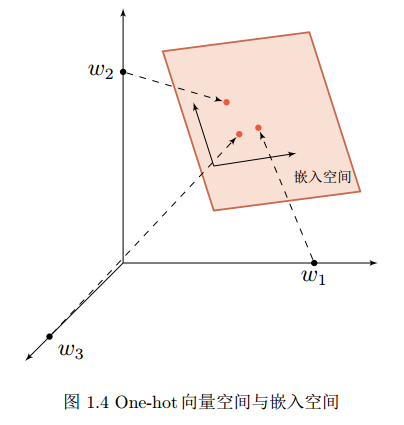

5表示学习

表示学习的关键问题是解决语义的鸿沟(Semantic Gap)。如果可以有一个好的表示在某种程度上可以反映出数据的高层语义特征,那么我们就可以相对容易地构建后续的机器学习模型。

有局部表示和分布式表示之分,局部表示通常可以表示成one-hot向量,高维度稀疏向量;分布式表示是低维的稠密向量。从高维到低维可以用嵌入Embedding实现

6 深度学习框架

TensorFlow, PyTorch, Caffe, Keras

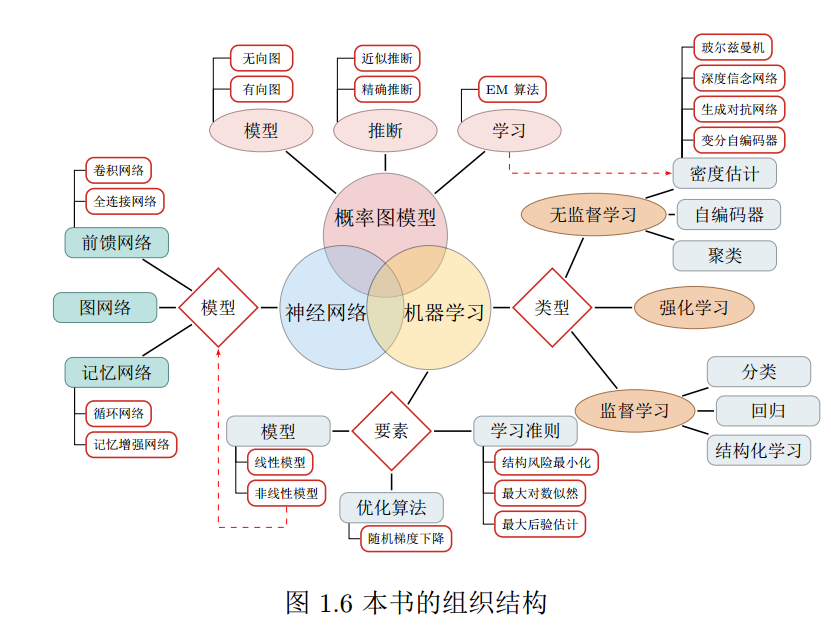

7 书籍框架