@zsh-o

2018-08-10T12:06:13.000000Z

字数 755

阅读 1868

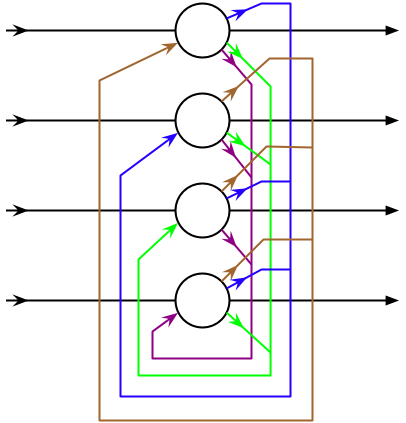

Hopfield网络 与 受限玻尔兹曼机

机器学习

Hopfield网络 与 Lyapunov方程

Hebbian 学习规则的原理和依据是什么,为什么是有效的

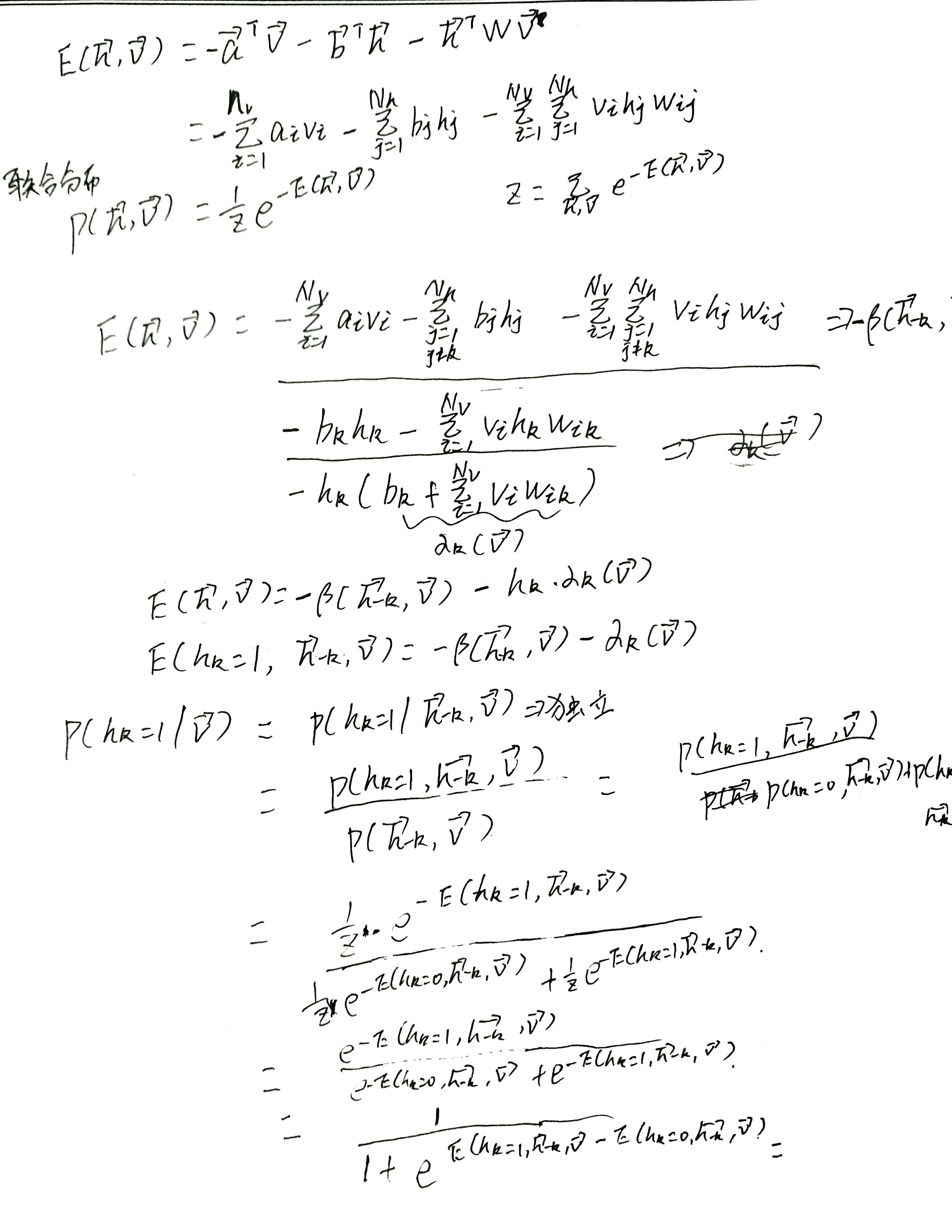

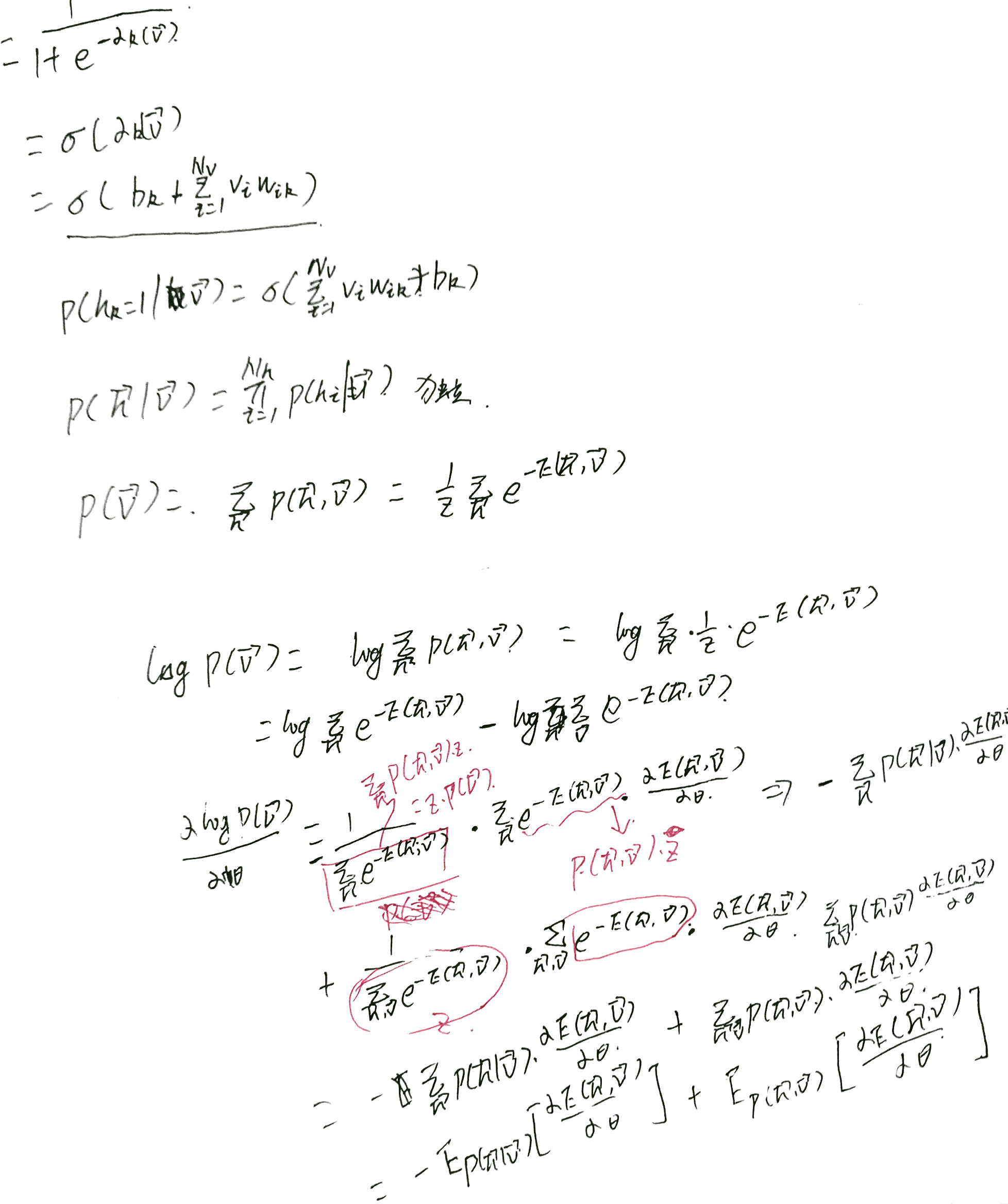

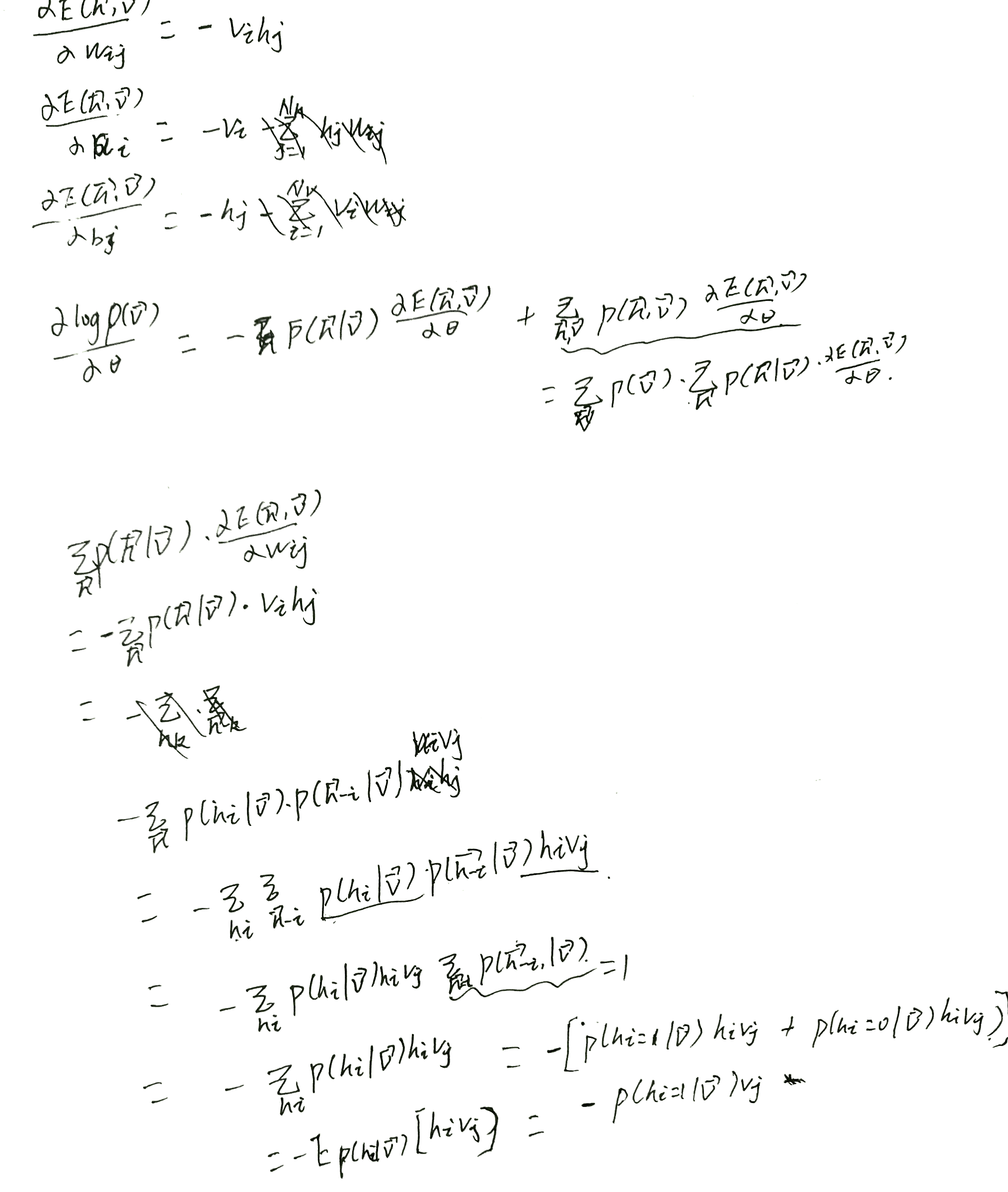

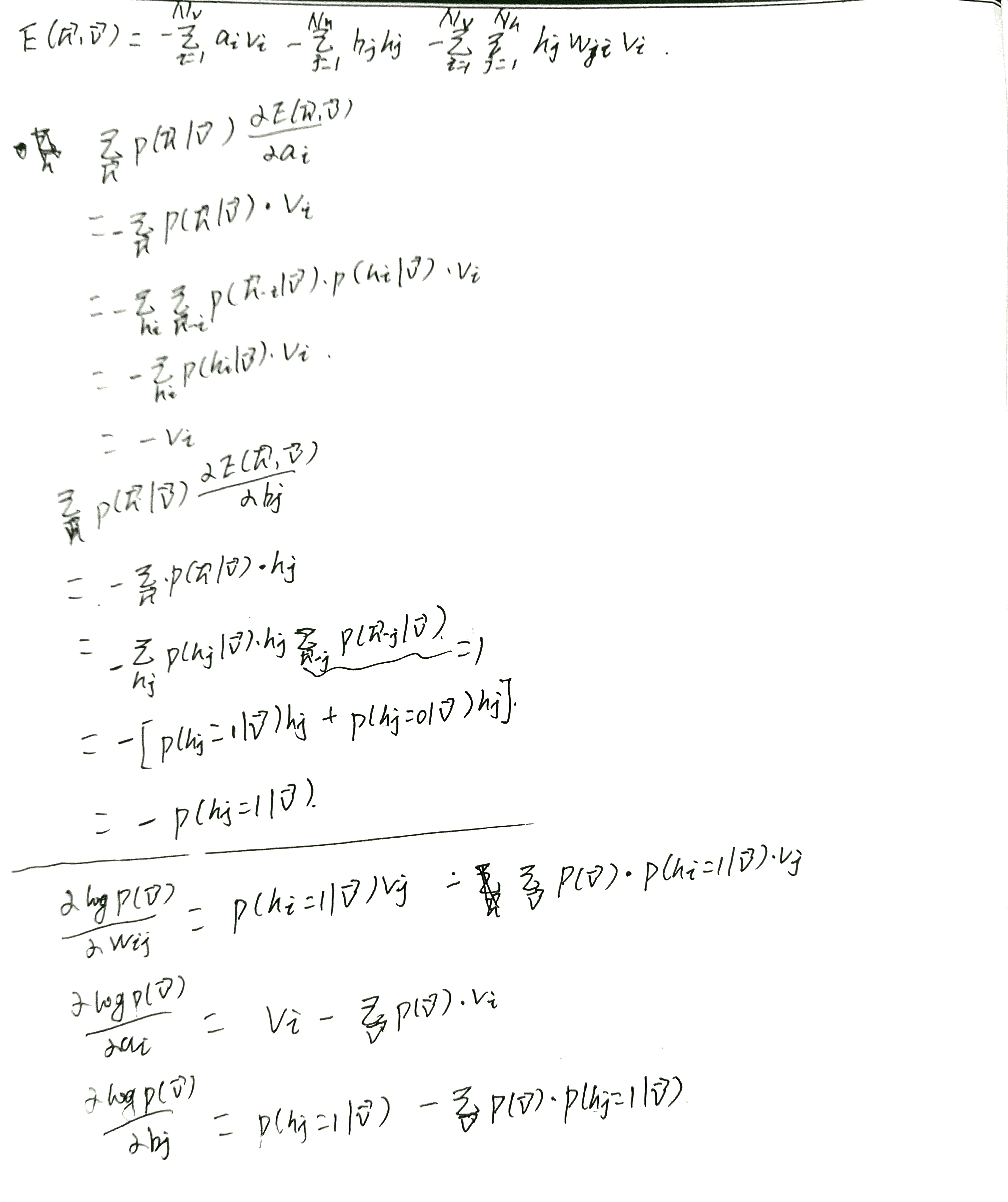

受限玻尔兹曼机

受限玻尔兹曼机能做什么,其隐层节点代表了什么,在传统的能量最小迭代中的隐层节点又代表了什么,其能否迭代到训练保存的稳定态,与玻尔兹曼机和Hopfield网络的区别和联系

基于Lyapunov方程的迭代到稳定状态的过程很像马尔科夫链的状态转移过程

到底是由Lyapunov方程推出的激活函数,还是由激活函数推出的Lyapunov方程,谁知道呢,反正其能相互推导,但应该由激活函数推导出Lyapunov方程比较合理一点,这样就能极大程度上一般化该模型

现在遇到的东西加随机的,都有种抽样的感觉,利用抽样或间接抽样来估计一个值,像随机梯度下降、玻尔兹曼机又叫做具有隐含节点的随机Hopfield网络(stochastic Hopfield network with hidden units)

玻尔兹曼机节点表示的概率,Hopfield网络节点表示的好像是状态,这样学习和迭代的过程就不用抽样,那能量的定义为什么不直接用分布来表示。。。。这其实也是模型结构造成的,玻尔兹曼机节点确实表示概率,但其传递的时候的线性模型却用的具体的某个状态而不是概率分布,二值受限玻尔兹曼机用观测向量具体的状态计算得到隐含向量的概率,而不是用一个概率计算另一个概率,故迭代过程需要抽样

- http://www.scholarpedia.org/article/Hopfield_network

- https://en.wikipedia.org/wiki/Boltzmann_machine