@sambodhi

2018-10-12T06:28:27.000000Z

字数 2643

阅读 2161

让机器人通过观摩视频来学会耍杂技

作者|XB. Peng、A.Kanazawa

译者|ZY. Liu

编辑|LX. Chen

AI前线导读:人类和动物智力的关键部分,就是模仿能力。什么是模仿能力呢?就是通过观察他人的做法来学习一项新技能。那么,人工智能是否能够通过观察视频剪辑来掌握某种技能呢?答案是肯定的,这不再是天方夜谭的幻想了,伯克利人工智能研究中心(Berkeley Artificial Intelligence Research,BAIR)已经实现了这一幻想。让我们看看,他们是如何让机器人通过观摩来学会耍杂技的。

模仿YouTube视频中的角色。

无论是洗手这样的日常动作,还是惊人的杂技表演,人类都能通过观察他人来学习一系列令人难以置信的技能。随着像YouTube这样的公开视频数据越来越多,现在,要找到我们感兴趣的任何技能的视频剪辑,比以往更容易了。每分钟都有超过300个小时的视频上传到YouTube。不幸的是,对我们的机器人来说,从大量的视觉数据中学习技能,仍然是一个巨大的挑战。大多数模仿学习方法都需要简洁的表示,例如从动作捕捉(motion capture,缩写mocap)记录的表示。但获取mocap数据可能是一件很麻烦的事,因为通常需要使用大量的仪器才能获取。mocap系统也往往局限于最小封闭空间的室内环境中,这点很可能会限制可记录的技能类型。如果我们的智能体也可以通过视频来学会技能,那岂不是很好?

为了解决这一目标,我们提出了一个从视频中学习技能(Learning skills from videos,SFV)的框架。通过结合计算机视觉和强化学习的最先进技术,我们的系统模拟角色能够从视频剪辑中学习各种各样的技能。给定一个演员表演某种技能的视频,比如侧手翻或后空翻,我们的角色就能够学习在物理模拟中重现这种技能的策略,而无需任何姿态的手动注释。

从视频中学会全身动作技能,在计算图形学领域中引起了一些关注。以前的技术通常依赖于手工制作的控制结构,这些控制结构对可以产生的行为有很强的约束性。因此,这些方法往往局限于可学习的技能类型,而且,由此产生的动作看起来相当不自然。最近的发展已经证明,在Atari等领域的视觉模仿以及相当简单的机器人任务方面,深度学习是大有希望的。但这些任务通常只是在演示和智能体环境之间只有适度的域转换,而持续控制的结果主要是在动态相对简单的任务上。

框架

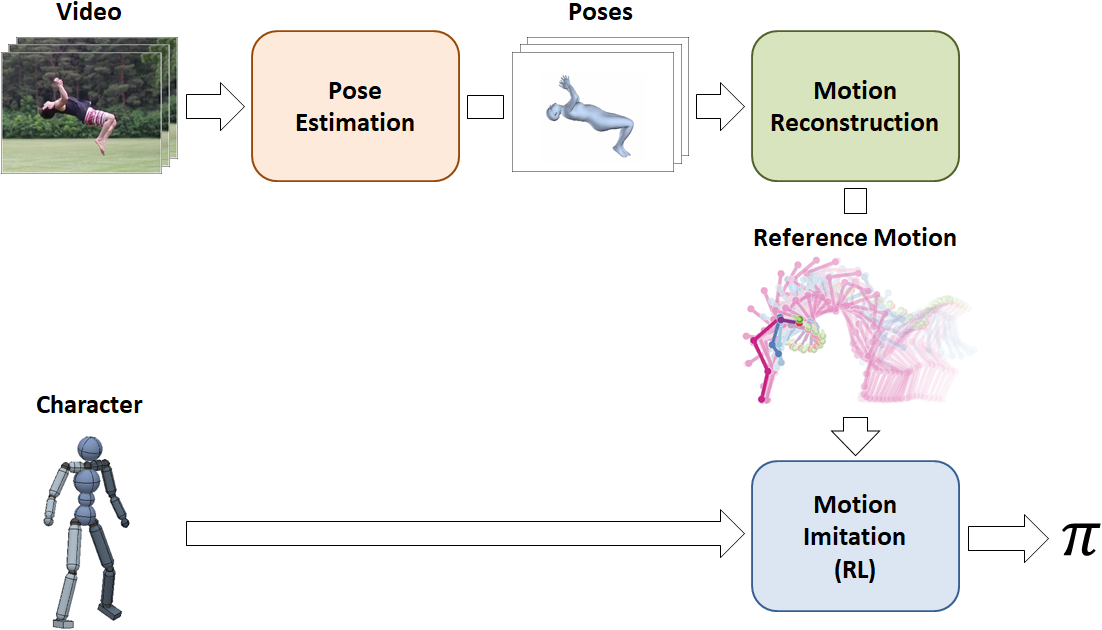

我们的框架结构是一个管道,由三个阶段组成:姿态估计、动作重建和动作模拟。输入视频首先在姿态估计阶段进行处理,姿态估计阶段预测每一帧中演员的姿态。接下来,动作重建阶段将姿态预测合并到一个参考动作中,并修复可能由姿态预测引入的伪影。最后,将参考动作传递到动作模拟阶段,通过训练模拟角色使用强化学习来模拟动作。

管道由三个阶段组成:姿态估计、动作重建和动作模拟。管道将某演员表演特定技能的视频剪辑和一个模拟角色的模型作为一个输入,并学习一个控制策略,使角色能够在物理模拟中再现该技能。

姿态估计

给定一个视频剪辑,我们使用一个基于视觉的姿态估计来预测演员在每一帧中的姿态。姿态估计器构建在人体网格恢复的工作之上,该网格使用弱监督的对抗式方法来训练姿态估计器来预测平面图像的姿态。虽然需要姿态注释来训练姿态估计器,但一旦训练完毕,姿态估计器就可以在没有任何注释的情况下应用于新图像。

基于视觉的姿态估计器用于预测每个视频帧中的演员姿态。

动作重建

由于姿态估计器针对每个视频帧独立地预测演员的姿态,因此帧间的预测可能会不一致,从而产生抖动的伪影。此外,虽然基于视觉的姿态估计器在最近几年来有了很大的改善,但它们仍然偶尔会犯一些相当大的错误,这样可能会时不时出现奇怪的姿态。这些伪影可以产生物理上根本不可能会出现的动作。因此,动作重建阶段的作用,就是减轻这些伪影,以便产生物理上更合理的参考动作,使模拟角色更容易模仿。为此,我们优化了新的参考动作 来满足以下目标:

来满足以下目标:

其中, 鼓励参考动作类似于最初的姿态预测,

鼓励参考动作类似于最初的姿态预测, 鼓励相邻帧中的姿态相似,以便产生更为平滑的动作。另外,

鼓励相邻帧中的姿态相似,以便产生更为平滑的动作。另外, 和

和 是不同损失的权重。

是不同损失的权重。

这一过程可以大大提高参考动作的质量,并可以从最初的姿态预测中修复许多伪影。

动作中间前后参考动作的比较。动作重建可减少许多伪影,并产生更为平滑的参考动作。

动作模拟

一旦我们有了参考动作 ,然后我们就可以继续训练模拟角色来模仿技能。运动模拟阶段使用的强化学习方法,与我们先前提出的模拟mocap数据的方法类似。奖励函数只是鼓励策略最小化模拟角色的姿态与重建参考动作

,然后我们就可以继续训练模拟角色来模仿技能。运动模拟阶段使用的强化学习方法,与我们先前提出的模拟mocap数据的方法类似。奖励函数只是鼓励策略最小化模拟角色的姿态与重建参考动作 在每一帧

在每一帧 中的姿态之间的差异。

中的姿态之间的差异。

同样,这种方法固然简单,但最终效果非常惊人,我们的角色能够学习各种具有挑战性的杂技技能,每个技能都是从视频演示中学习的。

模拟人形机器人通过模仿视频剪辑来学习各种技能。

结果

总的来说,我们的角色能够从YouTube收集的各种视频剪辑中学习20多种不同的技能。

我们的框架可以通过视频演示中学习大量的技能。

尽管我们的角色的形态迥异于视频中的演员,但这些策略仍然能够很好的再现许多技能。作为一个更极端的形态差异的例子,我们还可以训练模拟Atlas的机器人来模仿人类的视频剪辑。

通过模仿视频剪辑,模拟人形机器人学会了多种技能。

具有模拟角色的优点之一是,我们可以利用模拟将行为推广到新的环境中。在这里,我们的模拟角色学会了适应不规则地形的动作,而原始视频剪辑里,演员是在平地上表演技能的。

动作可以适应不规则的环境。

尽管环境与原始视频中的环境有很大的不同,但学习算法仍然为处理这些新环境制定了相当合理的策略。

总之,我们的框架实际上是采取了任何人在处理视频模仿问题时都能想得到的最明显的方法。关键在于,将问题分解为更易于管理的组件,为这些组件选择正确的方法,并将它们有效地集成在一起。然而,从视频中模仿技能仍然是一个极具挑战性的问题,而且有很多视频剪辑我们还不能做到再现:

这种灵活的舞步,比如这个江南style的剪辑,仍然难以模仿。

但令人鼓舞的是,仅仅通过整合现有的技术,我们就可以在这个具有挑战性的问题上取得相当大的进展。我们仍然有许多工作要做,我们希望,这项研究有助于激发未来的技术,使智能体能够利用大量公开的书品数据来获得真正惊人的技能。

要了解更多信息,请查看我们的论文和项目网页:

https://xbpeng.github.io/projects/SFV/index.html