@lunar

2016-04-01T07:03:59.000000Z

字数 1506

阅读 2370

Coursera Machine Learning Week7 SVM

MachineLearning Coursera

支持向量机SVM(Support Vector Machine)

1.从逻辑回归到SVM

在Logistics regression中,我们约定的cost function是:

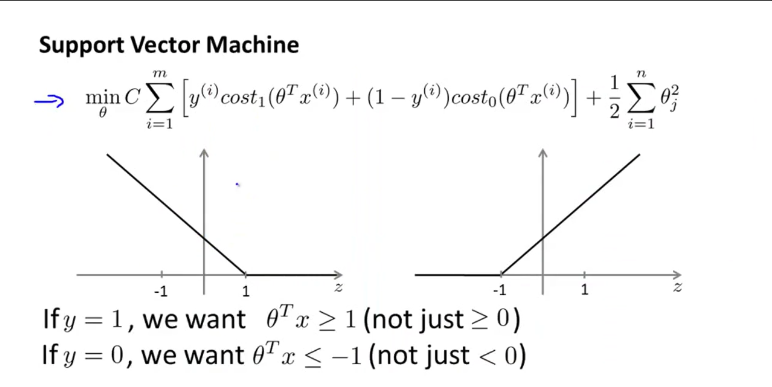

这里就是logistics函数,我们用两个近似函数和来替代他们,那么在SVM中

SVM hypothesis :

如果相对于样本个数来说,样本的特征个数较大也就是n较大时,使用逻辑回归。

如果n小,m中等,SVM(高斯).

如果n小,m大,逻辑回归。

2.大间距分类器 Large Margin Intuition

决策边界 Decision Boundary

margin指的是边界离样本的最近的距离,使margin最大化就是使cost function最小化的过程。因为使J变小也就是使变小(因为当C较大时我们会使前面那项尽可能为0,由此忽略)。但是因为时要有,所以要使小的话,就得大,也就是样本点离边界的距离要大,也就是margin要大。

异常点

SVM在处理异常点上会根据C的值来给定边界。

3.核函数 Kernels

新的特征变量

限定原有的特征变量组成的向量X=(),选择,那么可以使用x和l的相似度作为新的特征变量。这里的相似函数simrlarity也被称为核函数Kernel(这里用的是高斯核函数Gaussian Kernel)。

如何获得核

选择m个样本,将每一个都可以作为一个核。

核函数的本质

就是将原来的特征向量转换为一个新的更适合SVM处理的特征向量。

不同的核函数

- 线性核函数 (没有核函数)

- 高斯核函数,where

- 核函数需要满足 Mercer's Throrem从而使用各种数值优化算法。现在其他的核函数已经不多用了,它们有

- Polynomial kernel

- String kernel

- chi-square kernel等等

4.选择参数

Large C:Lower bias,high variance.

Small C:Higher bias,low variance.

Large:f分布更平滑,Higher bias,lower variance.

Small:较陡峭,Lower bias,Higher variance.

5.多类分类

训练K个SVM。