@xuemingdeng

2017-06-19T05:07:48.000000Z

字数 845

阅读 996

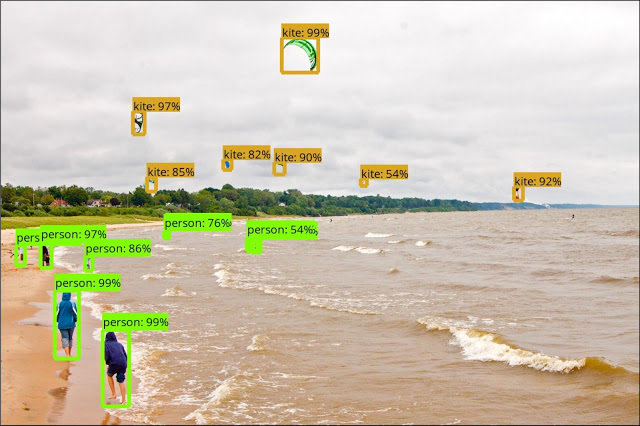

Google发布新的TensorFlow物体检测API

机器学习

Google发布TensorFlow物体检测API,帮助开发人员和研究人员识别图片中的物体。Google专注于提高API的易用性和性能,新的模型于6月16号发布,在基准测试中表现出良好的性能,并已经开始应用于研究工作当中。

物体检测API包含了高度依赖Inception的卷积神经网络和简化模型,这些模型可以运行在简单的机器上。比如,MobileNets单次检测器经过优化,能够以实时的方式运行在智能手机上。

早前,Google发布了轻量级的MobileNets计算机视觉模型家族,这些模型可以用于执行各种任务,如物体检测、面部识别和地标识别。

智能手机无法像台式机或基于服务器的环境那样处理计算资源,所以开发人员只有两种选择。机器学习模型可以运行在云端,但这样会增加延迟,而且要求使用网络连接——在很多情况下,这不是一种很好的解决方案。另一种方案是简化模型,这样就可以随心随欲地把它们署在设备上。

Google、Facebook和Apple已经在这些移动模型上投入了很多资源。去年秋天,Facebook发布了Caffe2Go框架,用于构建可在智能手机上运行的模型,而Facebook自己的Style Transfer就是第一个使用了该框架的项目。在今年的I/O大会上,Google发布了TensorFlow Lite,它是一种简化版的机器学习框架。而在刚刚结束不久的WWDC大会上,Apple发布了CoreML,CoreML旨在降低在iOS设备上运行机器学习模型的难度。

当然,因为Google公有云服务的关系,它与Facebook和Apple之间有一些差异化的定位,而且这不是Google第一次发布计算机视觉服务,比如之前的Cloud Vision API。

新发布的TensorFlow物体检测API可以在GitHub上找到。Google希望能够把它做得容易上手和实现,于是把整个工具套件都打成包,里面还包含了Jupyter Notebook。