@cww97

2017-10-15T09:47:17.000000Z

字数 1360

阅读 1251

机器学习

Assignment3: 数据中心化

陈伟文 10152510217

2017/10/15

关于中心化

以PCA为例说下中心化的作用。

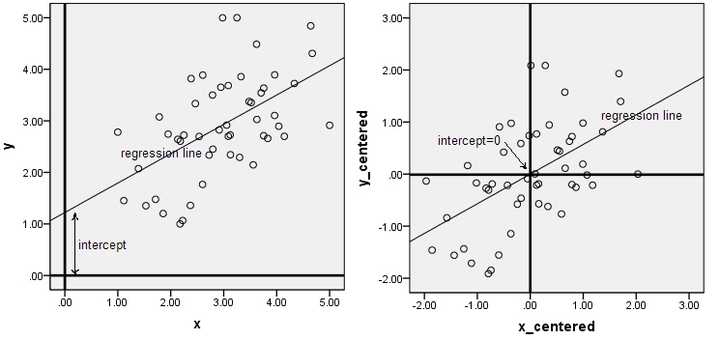

下面两幅图是数据做中心化(centering)前后的对比,可以看到其实就是一个平移的过程,平移后所有数据的中心是(0,0).

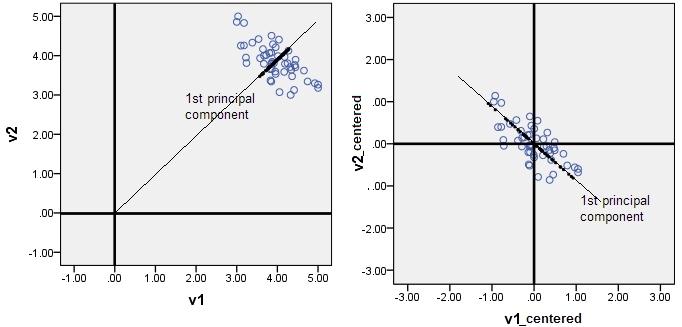

在做PCA的时候,我们需要找出矩阵的特征向量,也就是主成分(PC)。比如说找到的第一个特征向量是a = [1, 2],a在坐标平面上就是从原点出发到点(1,2)的一个向量。如果没有对数据做中心化,那算出来的第一主成分的方向可能就不是一个可以“描述”(或者说“概括”)数据的方向了。还是看图比较清楚。

黑色线就是第一主成分的方向。只有中心化数据之后,计算得到的方向才能比较好的“概括”原来的数据。黑色线就是第一主成分的方向。只有中心化数据之后,计算得到的方向才能比较好的“概括”原来的数据。

回头看题目

在对高维数据降维前应先进行“中心化”,常见方法是将协方差矩阵转换为,其中

主要分析H,中心化的作用就是减掉平均值,

把H带入原式,则

期中为单位矩阵,所以,

若数据为矩阵,即个数据维,

式子中的:一个 的单位列向量,

则即每一维度对应的均值

记为第个维度的均值

继续算下去,,一个的矩阵,每行为该维的均值

现在可以看出这个结果了:

,

实现了的效果,使得新的均值为

至于同理吧,不过,这个协方差矩阵为啥长这样还有些疑惑(可能是因为上课神游了)

老师下次讲题目的时候能不能提一下协方差矩阵啊