@ArrowLLL

2017-07-31T16:44:18.000000Z

字数 3926

阅读 8406

统计学习方法 —— 感知机

机器学习

Elon Lin

定义

假设输入空间(特征空间)是 ,输出空间是 。输入 表示实例的特征向量,对应输入空间(特征空间)的点;输出 表示实例的类别。由输入空间到输出空间的如下函数 :

称为感知机(perceptron)。

其中, 和 为感知机模型参数, 叫做权值(weight)或权值向量(weight vector), 叫做 偏置(bias), 表示 和 的内积。 是符号函数,即

假设空间 : 定义在特征空间中的所有线性分类模型(linear classification model) 或 线性分类器(linear classifier),即函数集合

感知机学习 : 由训练数据集(实例的特征向量与类别)

求得感知机模型 中的模型参数 。

感知机预测 : 通过学习得到的感知机模型,对于新的输入实力给出其对应的输出类别。

感知机学习策略

数据集的线性可分性

给定一个数据集

损失函数

假设训练数据线性可分,为了找到这个平面需要确定一个学习策略,即定义(经验)损失函数并将损失函数极小化

给定一个数据集

感知机学习的策略是在假设空间中选取是损失函数最小的模型参数,即感知机模型。

感知机学习算法

感知机学习算法是对以下最优化问题的算法。给定一个数据集

感知机学习算法是误分类驱动的,具体采用随机梯度下降法(stochastic gradient descent)。首先任意选取一个超平面 ,然后用梯度下降法不断地极小化目标函数。

假设误分类点结合 是固定的,那么损失函数 的梯度由

原始形式

极小化过程不是使 中所有误分类点的梯度下降,而是一次随机选取一个误分类点使其梯度下降。假设随机选取误分类点 ,对 进行更新 :

感知机学习算法的原始形式

输入:训练数据集 , 其中, ;学习率

输出:;感知机模型

- 选取初值 ;

- 在训练集中选取数据 ;

- 如果

- 转至 (2),直到训练集中没有误分类点。

算法收敛性

为方便描述将偏置 加入权重向量 ,记作 ,同样将输入向量加以扩充,加进常数 ,记作 。这样, 。显然,

Novlkoff 定理

设训练集

其中, , 则

1. 存在满足条件 的超平面 将训练数据集完全正确分开:且存在 ,对所有

2. 令 ,则感知机算法原始形式在训练数据集上的误分类次数k满足不等式

定理表明,误分类次数是有上界的,经过有限次搜索可以找到将训练数据完全正确分开的分离超平面。即数据可分时,感知机学习算法原始形式迭代收敛,但训练集线性不可分时,干主机学习算法不收敛,迭代结果会发生震荡。

对偶形式

对偶形式的想法是,将 表示为实例 和标记 的线性组合的形式,通过求解其系数而求得 。不失一般性,可假设原始形式中初始值 均为 。对误分类点 通过

这里,

感知机学习算法的对偶形式

输入:线性可分的数据集 ,其中 ;学习率

输出:;感知机模型

其中

- 在训练集中选取数据

- 如果

- 转至 2 直到没有误分类数据

对偶形式中,可以预处理训练集中实例间的内积并以矩阵存储,该矩阵即 Gram 矩阵(Gram matrix)

习题

Minsky 和 Papert 指出:感知机因为是线性模型,所以不能表示复杂的函数,如异或(XOR)。验证感知机为什么不能表示异或

已知异或表示对于同一集合的两个元素(a, b),a和b相同则为0, 相异则为1,由此可以得到其运算关系:

- (0, 0) = (1, 1) = 0

- (0, 1) = (1, 0) = 1

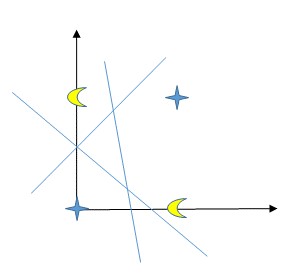

可得图像 :

由图像可以看出,XOR的训练集线性不可分,而感知机模型并不能学习线性不可分函数(linear insparable function)

证明以下定理:样本集线性可分的充分必要条件是正实例点集所构成的凸壳与负实例点所构成的凸壳互不相交。

必要性: 假设样本集T线性可分,则存在一个超平面 将数据集的正实例点和负实例点完全正确地划分到 的两侧。显然两侧的点分别构成的凸壳不相交;

充分性: 假设存在两个凸壳A、B相交,且存在超平面 将A和B线性分割。令A在B的凸壳内部的点为a,因为线性可分,则A中不存在两点之间的连线与超平面 相交,而凸壳B中任意一点与A中的点的连线均与超平面 相交,则B内部的点a也与A中任一点之间的连线不与 相交,与A中不存在两点之间的连线与超平面小脚矛盾。故只有正负实例点所构成的两个凸壳不相交时样本集才线性可分。