@SmashStack

2017-03-15T11:18:09.000000Z

字数 2579

阅读 1664

NVIDIA 人工智能与深度学习简报

Chore

深度学习简介

深度学习是人工智能(AI)中发展迅速的领域之一,可帮助计算机理解大量图像、声音和文本形式的数据。利用多层次的神经网络,现在的计算机能像人类一样观察、学习复杂的情况,并做出相应的反应,有时甚至比人类做得还好。

NVIDIA 致力于提供这样一种截然不同的方式,用于思考数据、技术以及人类所提供的产品和服务。

Machine Learning in GPU

海量训练数据的出现以及 GPU 计算所提供的强大而高效的并行计算导致了人们将这两个看似不同的两个领域进行了交融。

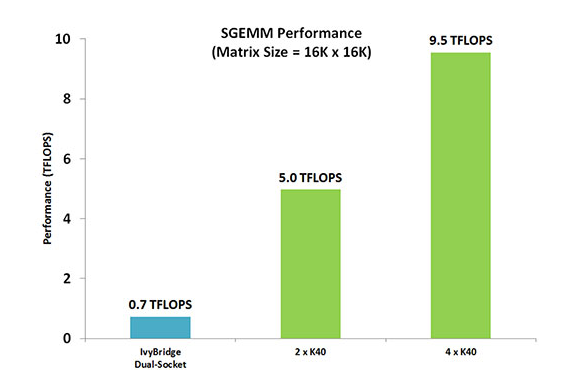

人们利用 GPU 来训练这些深度神经网络,所使用的训练集大得多,所耗费的时间大幅缩短,占用的数据中心基础设施也少得多。 GPU 还被用于运行这些机器学习训练模型,以便在云端进行分类和预测,从而在耗费功率更低、占用基础设施更少的情况下能够支持远比从前更大的数据量和吞吐量。

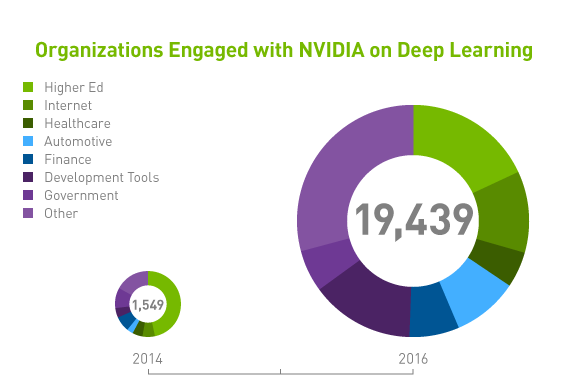

将 GPU 加速器用于机器学习的早期用户包括诸多规模的网络和社交媒体公司,另外还有数据科学和机器学习领域中一流的研究机构。 与单纯使用 CPU 的做法相比,GPU 具有数以千计的计算核心、可实现 10-100 倍应用吞吐量,因此 GPU 已经成为数据科学家处理大数据的处理器。

NVIDIA 的深度学习优势

NVIDIA 是加速深度学习发展方面的先行者,多年来一直致力于开发深度学习软件、库和工具。为训练诸如图像、笔迹和声音识别等颇具挑战的应用程序并加快训练速度,目前的深度学习解决方案几乎完全依赖 NVIDIA GPU 加速计算。采用 NVIDIA GPU 的深度学习系统具有以下优势:

加速的 DNN 和训练性能

NVIDIA GPU 特别擅长处理并行工作负载,可让网络提速 10-20 倍,从而将各个数据训练迭代周期从几个星期缩短为几天。实际上,GPU 在仅仅三年内便将深度神经网络 (DNN)的训练速度提高了 50 倍(这一速度远远超过摩尔定律),预计未来几年还将再提高 10 倍。快速的人工智能应用程序开发

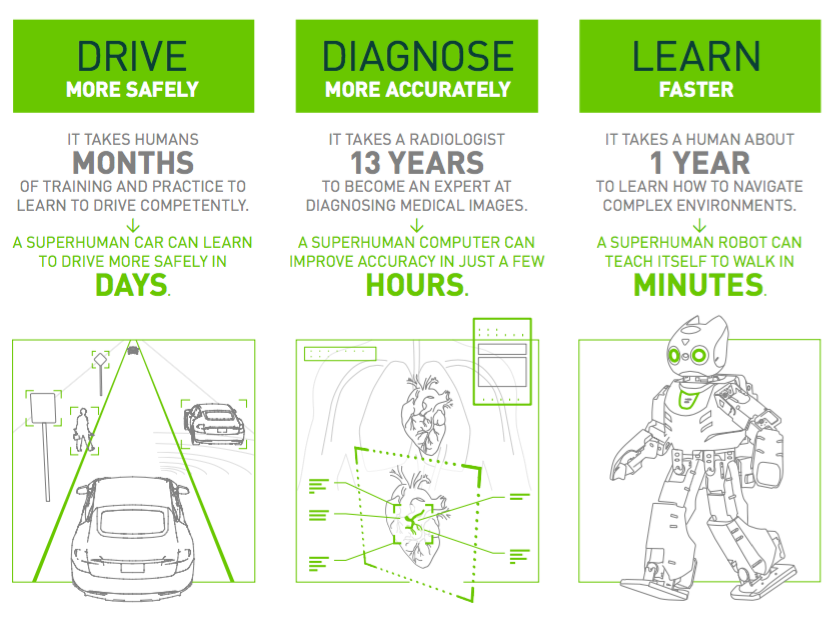

人工智能正以极快的速度进行创新。今天,计算机不仅是在学习,而且是在独立思考。这为机器人、医学和自动驾驶汽车等应用程序领域提供了好时机。您可以快速设计和部署深度学习应用程序,以利用这些不可思议的突破性技术。

NVIDIA is the main player in the GPU accelerated AI market

相关报告来自于此市场调研:Machine Learning in Business Use Cases

CUDA 可编程并行计算平台

多平台支持

In 2007 NVIDIA launched its compute unified device architecture (CUDA), a programmable parallel computing platform implemented in GPUs. CUDA programming provides the fastest and most versatile way to access the power of NVIDIA GPUs, with core supported languages C, C++, and Fortran. Third-party wrappers are available for Python, Java, Ruby, Lua, Haskell, R, Matlab, Mathematica, and others.巨大的市场占有量

In 2008 there were 150,000 downloads, 27 CUDA applications, 4,000 academic papers citing CUDA GPUs, 6,000 Tesla GPUs, and 77 supercomputing TeraFLOPS. In March 2015 there were 3 million CUDA downloads, 319 CUDA applications, 60,000 academic papers citing the platform, 450,000 Tesla GPUs in the market, and 54,000 supercomputing TeraFLOPS.高效强劲的计算能力

Nvidia announced its latest and fastest GPU at the GPU Technology Conference 2015. Titan X contains 3,072 CUDA cores, 8 billion transistors, 12 GB memory, and can achieve 7 TeraFLOPS in single precision. Its cost is $1,000. When combined with the new CUDA deep learning library (cuDNN), which provides primitives for connecting deep learning frameworks with CUDA, AlexNet, an example of a deep learning system, reduced its training time from a month to 2.5 days. This is a huge degree of acceleration.

DIGITS 开源 GPU 训练系统

Nvidia has also launched DIGITS, an open source Interactive deep learning GPU Training System, which is a complete system aimed at data scientists and others, without having to write code. Its features include:

- Visualization of deep neural network (DNN) topology and how training data activates a neural

network. - Management of training of many DNNs in parallel on multi-GPU systems.

- Simple setup and launch.

- Import of a wide variety of image formats and sources.

- Monitoring of network training in real time.

- Open source so DIGITS can be customized and extended as needed.