@wjcper2008

2017-02-28T15:39:08.000000Z

字数 4371

阅读 1793

SMO优化算法

机器学习基础 SVM

http://www.cnblogs.com/jerrylead/archive/2011/03/18/1988419.html

http://blog.csdn.net/xuanyuansen/article/details/41153023

1. SMO简介

SMO算法(Sequential minimal optimization)由Microsoft Research的John C. Platt 在1998年提出, 并成为最快的二次规划优化算法, 特别针对线性SVM和数据稀疏时性能更优。关于SMO最好的资料就是他本人写的《Sequential Minimal Optimization A Fast Algorithm for Training Support Vector Machines》了。

对于SVM的对偶问题, 数据集

2. SMO的更新公式推导

2.1 步骤一:视为一个二元函数

求解

- 按照坐标上升法(目标求最大值), 可固定除

αi 以外的所有的α , 然后在αi 上求极值.- 然而, 对于SVM, 由于约束条件

∑nk=1ykαk=0 . 如果固定其他的α , 那么αi 将不是变量.

因此, SMO算法需要同时选择两个

可以简化目标函数Const表示常数项(不包含

其中,

2.2 步骤二: 视为一元函数

等式约束

并代回到

2.3 对一元函数Ψ 求极值点

对

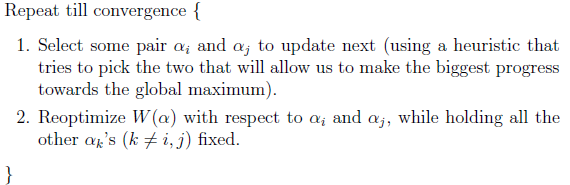

具体的算法步骤描述如下:

- 使用启发式算法选择更新的

αi 和αj 对, 使得目标值更新, 最大程度的向全局最优值逼近.- 固定其他参数,

W(α) 关于αi 和αj 求导, 得到子问题的极值. [而αj 又可由αi 表示]- SMO之所以高效就是因为在固定其他参数后,对一个参数优化过程很高效.

3. SMO的变量α 上界和下界

由

以及

当

对于

αi−αj=ϵ 情况, 有αi=αj+ϵ .

对于αi 的下界, 当αj=0 取得. 故,Lαi=max{0,ϵ}=max{0,αi−αj} .

对于αi 的上界, 当αj=C 取得. 故,Hαi=min{C,ϵ+C}=min{0,αi−αj+C} .对于

αj−αi=ϵ 情况, 有αi=αj−ϵ .

对于αi 的下界, 当αj=0 取得. 故,Lαi=max{0,−ϵ}=max{0,αi−αj} .

对于αi 的上界, 当αj=C 取得. 故,Hαi=min{C,−ϵ+C}=min{0,αi−αj+C} .

当

对于

αi+αj=ϵ 情况, 有αi=ϵ−αj .

对于αi 的下界, 当αj=C 取得. 故,Lαi=max{0,ϵ−C}=max{0,αi+αj−C} .

对于αi 的上界, 当αj=0 取得. 故,Hαi=min{C,ϵ}=min{0,αi+αj} .对于

αi+αj=−ϵ 情况, 有αi=−ϵ−αj .

对于αi 的下界, 当αj=C 取得. 故,Lαi=max{0,−ϵ−C}=max{0,αi+αj−C} .

对于αi 的上界, 当αj=0 取得. 故,Hαi=min{C,−ϵ}=min{0,αi+αj} .